איך משגרים לוויין? המסלול הגיאוסטציונרי ואופן פעולת הלוויין. ערוץ היוטיוב © ArvinAsh מעלה סרטוני הסברה קצרים על נושאים מורכבים ושאלות גדולות, בפשטות. הסרטון הפעם – איך לוויין עובד? כיצד הוא משוגר לחלל ונשאר במסלולו?

איך משגרים לוויין? תרגום תוכן הסרטון

כמה פעמים שמעתם מישהו מתאר קונספט קשה בביטוי "זה לא מדע טילים", כלומר, זה לא כל כך קשה להבנה כמו מדע טילים? מדע טילים מייצג עבור רבים את שיא הסיבוך. בטח הייתם רוצים להצהיר שאתם מבינים בתחום הזה ואפילו רואים בו אתגר גדול. אחרי הסרטון היום, תעשו בדיוק את זה. אני אציג בפניכם את אופן הפעולה של לווייני תקשורת ואת הדרך שבה משגרים אותם למסלולם.

למרות שיש כמה סוגים שונים של לוויינים, הסוגים האלה הם ככל הנראה בעלי ההשפעה הגדולה ביותר על חיינו היומיומיים. אבל כדי להבין מה הדברים האלה עושים ואיך הם משוגרים, תצטרכו ללמוד משהו על… ניחשתם נכון, מדע טילים. ואני מקווה שתגלו שזה באמת לא קשה כפי שזה נשמע.

אם אי פעם השתמשתם באפליקציית GPS למציאת מסלול, או אם בדקתם את מזג האוויר בעיר שלכם, או צפיתם בשידור טלוויזיה חי ממדינה זרה, יצרתם אינטראקציה עם לוויין. לוויינים משפיעים על חיי היומיום שלנו.

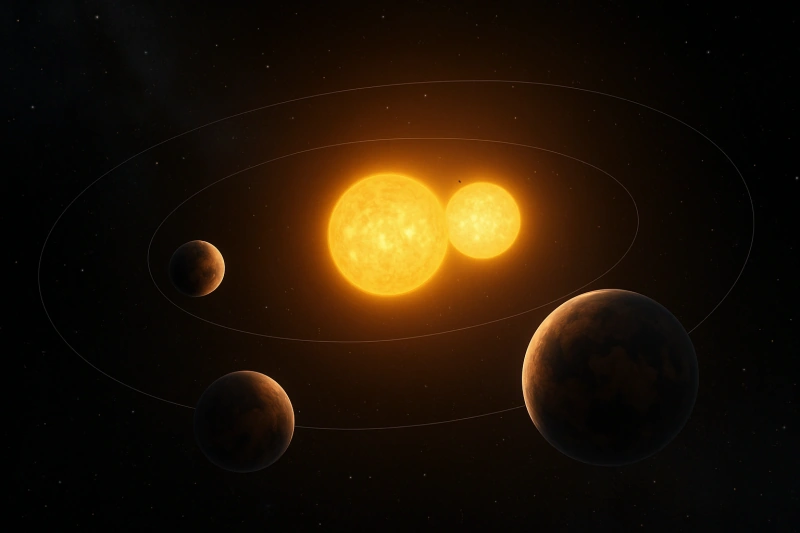

יש כמעט 3,000 לוויינים פעילים, בבעלות של יותר מ-100 מדינות שונות, המקיפים את כדור הארץ ממש עכשיו. ואלפים נוספים שמתוכננים לפעול בעתיד. כ-550 מהם נמצאים במה שנקרא מסלולים גאוסטציונריים. לווייני תקשורת נמצאים בדרך כלל במסלולים כאלה. זה אומר שהלוויין נראה נייח בהשוואה לסיבוב כדור הארץ. הוא נשאר באותה נקודה בשמיים בכל עת. במילים אחרות, אפשר לכוון את צלחת הלוויין שלכם שקולטת את תוכניות הטלוויזיה האהובות עליכם למצב אחד, ולעולם לא תצטרכו לשנות את הכיוון שלה.

חוקי קפלר וניוטון

אז השאלה היא איך מדענים מחשבים היכן למקם את הלוויין כך שישאר באותה נקודה בחלל? מכניקת מסלולים מבוססת על חוקי התנועה הפלנטרית של קפלר, שפורסמו כבר בשנת 1609. גם חוקי הגרביטציה האוניברסליים של ניוטון, שפורסמו ב-Principia Mathematica בסביבות 1687, ממלאים תפקיד בחישובים רבים.

חוקי קפלר מאפשרים לנו לחשב את המחזור והמהירות של לוויין כזה. המהירות היא שורש ריבועי של mu חלקי r, כאשר mu הוא הפרמטר הכבידה הסטנדרטי, שהוא קבוע הכבידה של ניוטון כפול מסת כוכב הלכת. r הוא רדיוס הלוויין ממרכז כדור הארץ. והמחזור מחושב לפי הנוסחה: T = 2π√r^3/mu. שימו לב שהמהירות והמחזור תלויים רק ברדיוס הלוויין, ולא במסה שלו.

מסלול גאוסטציונרי

מסלול גאוסטציונרי הוא מעגלי, ומכיוון שגובה הלוויין אינו משתנה, מהירותו חייבת להיות קבועה. אם תעשו את החישובים, תגלו שהמסלול הגאוסטציונרי נמצא במרחק של 35,786 ק"מ מקו המשווה. מחזור המסלול הוא 23.93 שעות, או 23 שעות ו-56 דקות. אולי תהיתם, למה זה לא בדיוק 24 שעות? ובכן, 23 שעות ו-56 דקות למעשה שוות ליממה סדרלית אחת. זהו הזמן שלוקח לכדור הארץ להשלים סיבוב אחד ביחס למסגרת ייחוס שאינה מסתובבת.

הסיבה שאנחנו בדרך כלל סופרים 24 שעות כיממה אחת, היא מכיוון ש-24 שעות זה הזמן המדויק שהשמש חוזרת לאותה נקודה בשמיים מדי יום. אבל אתם צריכים לזכור שכדור הארץ נע ביחס לשמש. כדור הארץ נע ב-1/365 מהמעגל סביב השמש בזמן הזה. זה בערך 4 דקות. במילים אחרות, כדור הארץ צריך להסתובב עוד קצת, בערך 4 דקות, כדי שהשמש תהיה בדיוק מעליו. אבל סיבוב מלא סביב צירו נמשך בפועל 4 דקות פחות מכך.

איך הלוויין מוכנס למסלול

כעת השאלה היא איך לוויין תקשורת מוכנס למסלול כזה? השלב הראשון הוא לשגר את הלוויין על טיל שיש לו קיבולת מטען כדי לשאת את הלוויין למסלול זה, ויכול להעניק את המהירות הדרושה כדי לשמור על מסלול זה. בארצות הברית, הטיל המרכזי למשימה זו הוא האטלס V.

טיל זה שוקל כ-317,000 ק"ג בזמן השיגור ויכול לשגר כ-12,700 ק"ג למסלול גאוסטציונרי. 90% ממשקלו הוא הדלק, שזה אופייני לטילים. המנוע הראשי מופעל על ידי חמצן נוזלי ו- RP-1, שהיא צורה מזוקקת מאוד של נפט, בדומה לדלק סילוני.

איך הטיל עובד

איך טיל עובד? ראשית, טיל לא זקוק לאטמוספירה כדי לחמצן את הדלק כמו שמנוע סילון עושה. הסיבה לכך היא שהוא נושא את המחמצן שלו. זה מאפשר לו לתפקד בחלל החיצון שבו אין אטמוספירה. מנוע סילון לא יעבוד שם כי אין חמצן זמין לשריפת הדלק.

מנועי טילים הם יישום של החוק השלישי של ניוטון, לכל פעולה, יש תגובה שווה והפוכה. שריפת הדלק גורמת לגזי פליטה בלחץ גבוה להיפלט במהירות על-קולית. התאוצה לאחור של מסת הדלק העוזבת את הזרבובית של הטיל גורמת לתגובה השווה וההפוכה של דחף קדימה שמניע את הטיל קדימה או כלפי מעלה במהלך השיגור. צורת הזרבובית של הטיל מתוכננת להגביר את מהירות גזי הפליטה עוד יותר כדי להגביר את הדחף שלו. הדחף הגבוה ביותר מושג כאשר קצב זרימת המסה של הדלק ומהירות היציאה של ההנעה גבוהים על פי משוואה זו.

הדלק צריך להיות מסופק בנפח ובלחץ גבוהים כדי לקבל את הדחף הנדרש להרמה. לחץ זה מסופק על ידי משאבות דלק שמגבירות את לחץ הגזים לפני כניסתם לתא הבעירה. מכיוון שמשאבות אלו יכולות להגביר את הלחץ, אין צורך לדחוס את הדלקים בלחץ כל כך גבוה. וניתן להפחית את עובי מיכלי האחסון שלהם, מה שגורם לחיסכון במשקל, וקיבולת מטען מוגברת.

איך עובדות משאבות הדלק

כעת אולי תשאלו, איך פועלות המשאבות הללו? בדרך כלל, כמות קטנה של דלק מניעה טורבינה, וזו בתורה מפעילה את המשאבה. שמירה על טיסה יציבה וישרה היא אתגר. בעבר, טילים יוצבו באמצעות סנפירים גדולים. טיסה יציבה מחייבת שמרכז הלחץ יהיה נמוך ממרכז הכובד. בנקודה זו הכוח האווירודינמי מפעיל את השפעתו ושומר על יציבות הכלי."

בנקודה זו פועל הכוח האווירודינמי המייצב את הטיל. הסיבה לכך היא שאם זווית ההתקפה שלו משתנה ביחס לנתיב הטיסה שלו, הכוח הפועל מתחת למרכז הכובד יכול להחזיר את היציבות שמיישרת מחדש את חרטום הטיל.

עם זאת, טילים מודרניים לא משתמשים בסנפירים, בגלל המשקל הנוסף והגרר האווירודינמי שהם גורמים. היציבות מגיעה מסיבוב זרבובית הדחף כדי לשמור עליה יציבה. זה נקרא דחף ממוזער.

שינוי המסלול

מסלול גאוסינכרוני מושג בשלבים. בדרך כלל, הטיל ייקח את הלוויין לגובה המסלול שלו, אבל המסלול ההתחלתי הוא אליפטי. מסלול אליפטי זה צריך להשתנות למסלול מעגלי כדי להפוך לגאוסטציונרי.

אז לדוגמה, מסלול אליפטי עשוי לקחת את הלוויין לגובה של 150 ק"מ, בנקודה הנמוכה ביותר שלו, הנקראת פריגיאה. ולמסלול הגיאוסטציונרי של 35,786 ק"מ בגובה הגבוה ביותר שלו, ה-אפוגיאה. אנחנו יכולים להשתמש בחוקי קפלר כדי לחשב את המהירויות שיהיו לו בנקודות אלה – כ-36,500 קמ"ש בפריגיאה, ו-5,800 קמ"ש באפוגיאה.

הלוויין ממשיך במסלול אליפטי עד שמשהו משנה את מסלולו. שינוי זה נעשה ע"י האצת הטיל בדיוק בזמן הנכון כדי להפוך את המסלול בהדרגה למעגלי. עלינו להפעיל את המנועים בדיוק בנקודת האפוגיאה כדי להאיץ את החללית מ-5,800 קמ"ש ל-11,000 קמ"ש. זו המהירות שהיא צריכה כדי לשמור על מסלול גאוסטציונרי מעגלי.

"נדל"ן" מוגבל

כפי שאתם יכולים כנראה להבין, יש רק מסלול גאוסטציונרי אחד. והוא נמצא בגובה של 35,786 ק"מ מעל קו המשווה של כדור הארץ. אין מסלול גאוסטציונרי אחר. ויש 500 לוויינים בגובה הזה. ה-"נדל"ן" הזה, אפילו בחלל, הוא מוגבל. ההיקף הכולל הזמין הוא כ-265,000 ק"מ. זו לא הייתה בעיה אם כל אחד מ-500 הלוויינים היה ממוקם במרחק שווה זה מזה והיה מרווח של 500 ק"מ ביניהם.

אבל זו לא הדרך שבה העולם עובד. יש הרבה יותר לוויינים מעל האזורים המפותחים של כדור הארץ. הם לפעמים במרחק של פחות מ-10 ק"מ זה מזה. והמהירות שבה הם צריכים לנוע היא 11,000 קמ"ש, או 3 ק"מ בשנייה, אין הרבה מקום. הם מרוחקים פחות מ-4 שניות זה מזה. לכן זה שטח נדל"ני יקר, כפי שאתם יכולים לתאר לעצמכם. והוא מנוהל על ידי ארגון האיגוד הבינלאומי לטלקומוניקציה (ITU) שמקצה לכל לוויין מיקום ספציפי במסלול.

קו המשווה

בנוסף, אם הטיל לא משוגר מקו המשווה, המסלול שלו לא יהיה באמת גאוסטציונרי. מכיוון שהוא לא יהיה בקו ישר או באותו מישור ביחס לקו המשווה. אז לדוגמה, כאשר לוויינים משוגרים מקייפ קנוורל, פלורידה, שנמצא בקו רוחב של כ-28.5 מעלות צפון, המסלול יהיה נטוי ב-28.5 מעלות מקו המשווה. מה שדורש תיקון = שימוש ביותר דלק.

לכן, מדינות מעדיפות לשגר טילים קרוב ככל האפשר לקו המשווה כדי לחסוך בדלק הנדרש להתאמת המסלול. שיגור מקו המשווה מעניק לטיל אינרציה (התמדה) נוספת בזכות מהירות הסיבוב הגבוהה של כדור הארץ באזור זה. כך, הטיל נהנה ממהירות הסיבוב של כדור הארץ עוד לפני רגע השיגור עצמו.

שימו לב שלא כל לווייני התקשורת ממוקמים במסלולים גאוסטציונריים. חלקם ממוקמים גם במסלול נמוך סביב כדור הארץ. לווייני מסלול נמוך (LEO) סביב כדור הארץ יכולים לשרת את אותה פונקציה, אבל צריכים להשתמש בהרבה מהם כשהם נעים במהירויות כה גבוהות. וחייבת להיות העברה מתמדת של שידורים מלוויין אחד למשנהו. לוויינים אלו מוזילים משמעותית את עלויות הייצור והשיגור. מכיוון שהם פועלים בטווחים קצרים, אין צורך בציוד שידור חזק ויקר, מה שמפשט את מבנה הלוויין וחוסך במשאבים

מה קורה לאחר הצבת הלוויין במסלול?

אז מה קורה עכשיו, כשסוף סוף יש לנו את הלוויין שלנו במסלול סביב כדור הארץ, התאמנו אותו כדי שיהיה לו מסלול גאוסטציונרי מעגלי, הצבנו אותו במקום הנכון שהוקצה על ידי ה-ITU והתאמנו את זווית המסלול שלו כך שיהיה באותו מישור כמו קו המשווה?

עם תחילת פעולתו, הלוויין פותח לוחות סולאריים המספקים לו את הכוח הדרוש. כעת הוא יכול לבצע את משימתו העיקרית: קליטת אותות מכדור הארץ, הגברתם ושידורם המיידי חזרה בתדרים שונים.

מכיוון שגלי רדיו הם צורה של קרינה אלקטרומגנטית, כמו אור, הם לא מתעקמים הרבה עם קימור כדור הארץ. אחרי הכל, הפוטונים מהירים מדי. תפקיד הלוויין הוא לשדר גלי רדיו למרחקים ארוכים. אחרת, זה ידרוש שרשרת של אלפי תחנות ממסר על פני כדור הארץ כדי לבצע את אותה משימה.

לוויינים אלה בדרך כלל כוללים לפחות שתי אנטנות שעשויות להיות מכוונות לשתי נקודות שונות בקרקע. כל אחת מהן משמשת הן לשידורים נכנסים והן לשידורים יוצאים. אנטנות אלה בדרך כלל גדולות ככל האפשר כדי לקלוט אותות חלשות יותר מכדור הארץ. אבל הקוטר מוגבל ל- 3 מטרים, עקב מגבלות הגודל בתוך הטיל.

הקהילה המדעית מעניקה לעיתים למסלול הגאוסטציונרי את הכינוי 'מסלול קלארק'. זוהי מחווה לארתור סי קלארק, מחבר הספר '2001: אודיסיאה בחלל', שחזה את השימוש במסלול זה. הוא היה האדם הראשון שפירט את התועלת של מסלול כזה בסיפור שכתב עוד בשנת 1945. זה אומר לכם שמדע בדיוני יכול לפעמים לחזות עובדות מדעיות עתידיות.

בפעם הבאה שאתם צופים בטלוויזיה לווינית, משתמשים ב-GPS, מאזינים לרדיו או בודקים את מזג האוויר. תחשבו על מדע הטילים והטכנולוגיה המדהימה שמאפשרת לנו ליהנות מהטכנולוגיות המדהימות האלה.

כדי להישאר מעודכנים בתכנים חדשים הצטרפו לדף הפייסבוק שלנו

כדי להישאר מעודכנים בתכנים חדשים הצטרפו לדף הפייסבוק שלנו